La inteligencia artificial (IA) no se queda en mantener conversaciones: su objetivo es crear sistemas que comprendan, razonen e interactúen con el mundo, ya sea organizando reuniones, analizando datos de mercado en tiempo real o diseñando campañas de marketing muy segmentadas. La llegada de los modelos de lenguaje a gran escala (LLM) como ChatGPT, Claude y Mistral ha acercado esa meta, pero conectar estos modelos con herramientas externas sigue siendo un problema de integración, con enfoques muy distintos y, con frecuencia, poco compatibles entre sí.

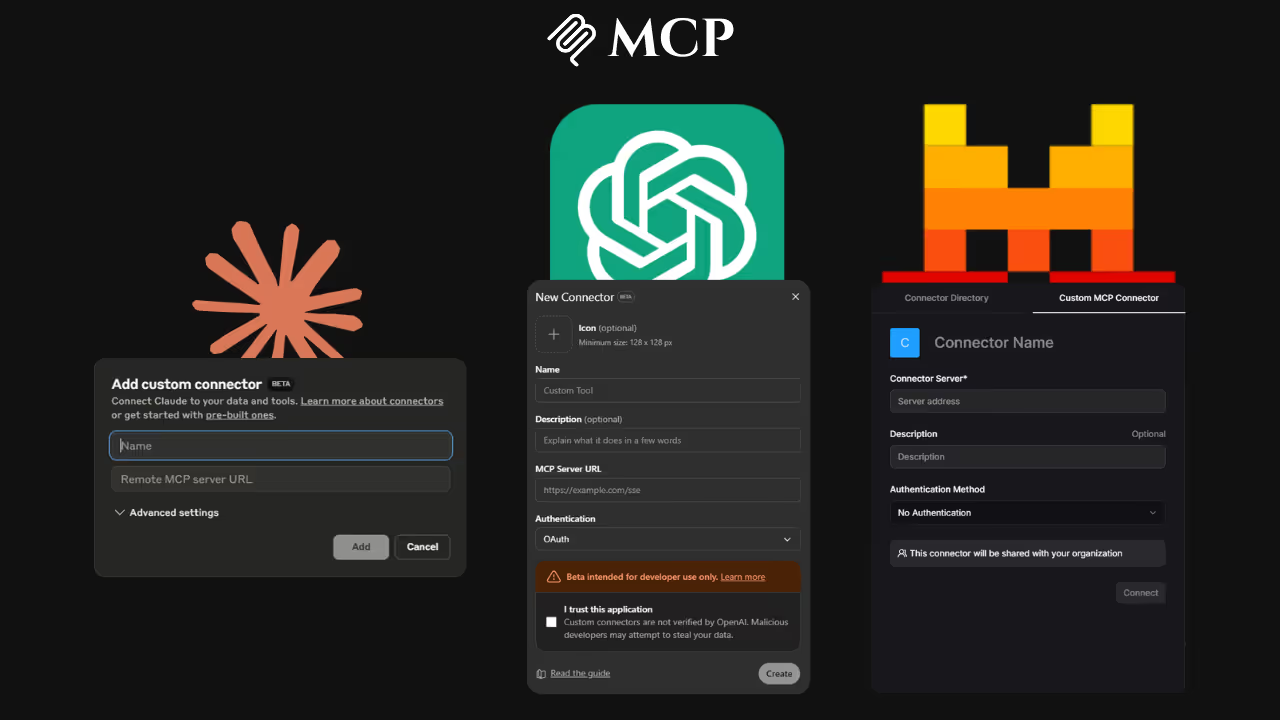

Ahí entra el Model Context Protocol (MCP). Este estándar de código abierto, presentado originalmente por Anthropic (creadores de Claude), se está consolidando como el marco de referencia para conectar LLMs con servicios y herramientas externas. Ofrece a los desarrolladores una terminología y unas pautas comunes para crear agentes de IA que realicen tareas del mundo real sin fricciones.

Aunque el MCP establece una base común, cada proveedor lo utiliza y adapta a su manera, lo que refleja diferentes filosofías, puntos fuertes y casos de uso ideales. Para quienes trabajan en marketing, SEO, estrategia de contenidos o desarrollo, entender estas diferencias es crucial.

En este artículo encontrarás una comparación detallada de cómo funciona el MCP con ChatGPT, Claude y Mistral, que te ayudará a elegir la plataforma que mejor se ajuste a tus objetivos y necesidades técnicas.

Model Context Protocol (MCP): Qué es y cómo funciona

Antes de ver cómo trata cada LLM el MCP, conviene entenderlo bien. En pocas palabras, el MCP es un estándar abierto que facilita que los modelos de lenguaje se comuniquen con herramientas externas. Piensa en él como una API común: establece un formato único para indicar acciones al modelo, por ejemplo: “buscar en la web”, “enviar un correo” o “actualizar una base de datos”, independientemente del LLM que uses.

El MCP sigue un modelo cliente-servidor:

- Un servidor MCP ofrece un conjunto de herramientas (la API de tu CRM, una función de búsqueda web, un servicio de envío de correos, etc.) accesibles por los modelos conectados.

- El LLM, en calidad de cliente, recibe la petición del usuario, decide qué herramienta utilizar, formatea la solicitud según el MCP y la envía al servidor.

- El servidor MCP procesa la petición y devuelve la respuesta al LLM.

Estandarizar este flujo hace mucho más sencillo construir agentes de IA potentes y reutilizables. Aun así, la elección del LLM sigue siendo importante: condiciona el desarrollo, las capacidades prácticas y los resultados que puedes esperar.

Cómo implementan el Model Context Protocol (MCP) los principales LLM

Aunque el MCP establece un marco común, Claude, ChatGPT y Mistral lo aplican de maneras distintas según sus fortalezas, su filosofía de diseño y el tipo de usuario al que se dirigen. Cada proveedor adapta el protocolo para optimizar casos de uso concretos, por lo que la elección del modelo influye tanto en la integración técnica como en el comportamiento y rendimiento del agente.

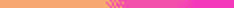

1. ChatGPT: integración del ecosistema a gran escala

La adopción del MCP por parte de ChatGPT es una jugada estratégica que refleja el objetivo de OpenAI de ampliar aún más su enorme plataforma, a la vez que aborda la necesidad de un enfoque más estandarizado para la integración de herramientas, más allá de sus propios plugins y las acciones de los GPTs personalizados.

- Filosofía: ChatGPT es una plataforma de IA ampliamente adoptada y muy versátil, usada en muchos sectores por sus capacidades generales y su base de conocimiento extensa. Su enfoque con el MCP es el de integrar el ecosistema: con una comunidad de usuarios y desarrolladores ya masiva, el MCP actúa como un puente que conecta ese ecosistema con herramientas externas de forma más estandarizada y preparada para el futuro. Es una manera de potenciar la plataforma usando un estándar abierto.

- Ventajas clave:

- Acceso a una gran base de usuarios: para los desarrolladores, integrar herramientas vía MCP en GPTs personalizados ofrece una exposición y adopción difícil de igualar dentro del ecosistema de ChatGPT.

- Entorno de desarrollo familiar: quienes ya conocen los GPTs personalizados y cómo configurar sus acciones podrán ampliar fácilmente esas capacidades añadiendo servidores MCP, apoyándose en las herramientas y la documentación que ofrece OpenAI.

- Conectividad entre ecosistemas: el MCP permite que ChatGPT se conecte con herramientas que también pueden usar otros LLM, favoreciendo la interoperabilidad y aprovechando al mismo tiempo la potencia de la plataforma de ChatGPT.

- Retos: aunque el soporte es sólido, la convivencia del MCP con las propias "Actions" y "Plugins" de OpenAI puede dar lugar a un proceso de integración más fragmentado que el enfoque más unificado de Claude. Los desarrolladores tendrán que decidir entre usar las Actions propietarias o el MCP, según lo que mejor se ajuste a sus necesidades dentro de ChatGPT.

- Ideal para: proyectos dirigidos a una audiencia amplia, de consumo o profesional, que ya utilicen ChatGPT, o para quien quiera integrar herramientas de terceros populares manteniendo una experiencia de usuario fluida dentro de la interfaz de ChatGPT.

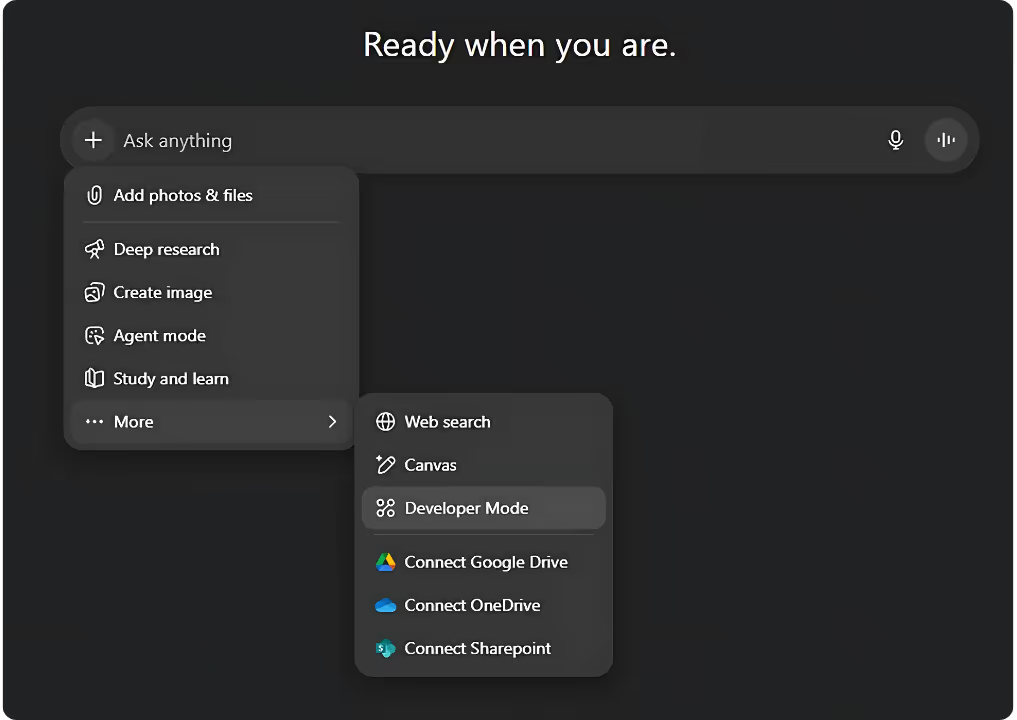

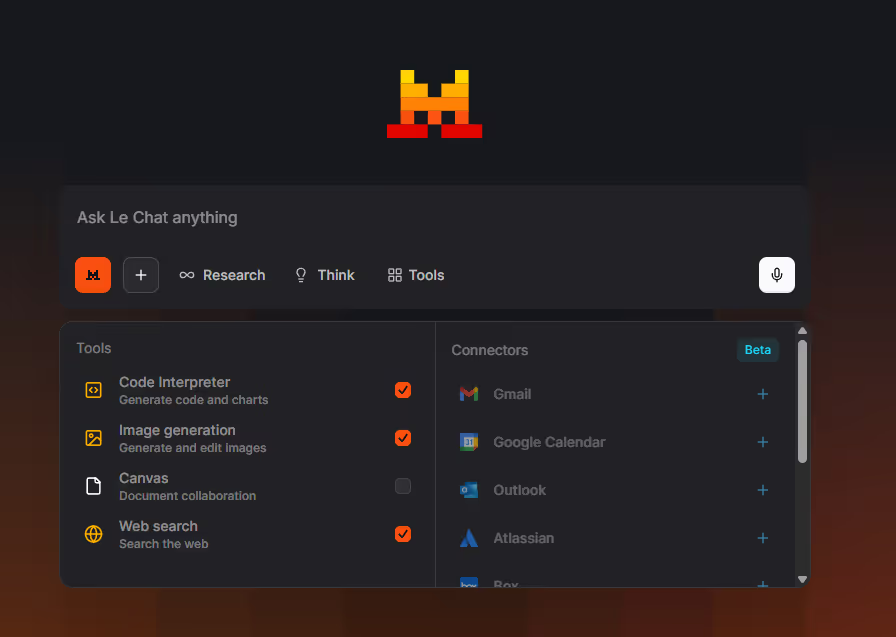

2. Claude: integración nativa y sin fricciones

Para Claude, el Model Context Protocol no es una función más: forma parte del propio diseño. Dado que Anthropic fue quien creó el MCP, su integración con Claude está pensada desde cero, convirtiéndolo en un componente esencial y muy pulido del sistema.

- Filosofía: Claude es una IA avanzada orientada a desarrolladores y usuarios técnicos que necesitan crear artefactos complejos y resolver problemas sofisticados. En Claude, el MCP encaja de forma natural: el protocolo se integra con el modelo para ofrecer una experiencia coherente y fiable. El objetivo es proporcionar una solución de agente potente y segura que funcione sin fricciones dentro del ecosistema de Anthropic.

- Ventajas clave:

- Fiabilidad fuera de serie: al ser una integración de primera mano, la relación entre Claude y el MCP suele ser la más estable y eficiente, con mínima fricción y rendimiento consistente.

- Experiencia refinada: los desarrolladores en el entorno Claude se benefician de mejoras continuas y optimizaciones por parte de Anthropic, lo que facilita el trabajo de desarrollo.

- Seguridad integrada: como Anthropic desarrolló el protocolo, las medidas de seguridad están profundamente incorporadas, ofreciendo protecciones sólidas para la ejecución segura de herramientas.

- Retos: aunque Claude destaca en su propio ecosistema, esa integración profunda puede reducir la flexibilidad para proyectos que necesiten alternar con frecuencia entre distintos proveedores de LLM. Es una experiencia premium con menos margen de adaptación.

- Ideal para: proyectos que requieren alta fiabilidad, consistencia y una experiencia de agente muy cuidada, especialmente para equipos ya comprometidos con el ecosistema Anthropic o que necesiten seguridad de primer nivel en un entorno gestionado.

3. Mistral: la interoperabilidad de código abierto en estado puro

La filosofía de Mistral, modelos con pesos abiertos, control para desarrolladores y eficiencia, encaja a la perfección con el Model Context Protocol. Para Mistral, el MCP no es un añadido: es un pilar a la hora de construir un ecosistema de IA realmente abierto y flexible.

- Filosofía: Mistral apuesta por la interoperabilidad abierta junto a un enfoque priorizando la privacidad y la seguridad. Sus modelos se alojan en centros de datos de la UE con instalaciones certificadas bajo la norma ISO 27001 para maximizar la protección de datos. La aproximación de Mistral al MCP se centra en dar control a los desarrolladores: la idea es permitir crear agentes de IA flexibles y preparados para el futuro sin dependencia de un único proveedor, aprovechando además la eficiencia de sus modelos.

- Ventajas clave:

- Máxima portabilidad: la combinación de modelos con pesos abiertos de Mistral y el estándar abierto MCP hace que tu agente de IA sea muy portable. Puedes cambiar fácilmente entre distintos modelos de Mistral, o incluso a otros LLM compatibles con MCP, sin rehacer por completo las integraciones de herramientas.

- Más control sobre los datos: para organizaciones que deben mantener datos sensibles en sus instalaciones, desplegar modelos de Mistral localmente junto a un servidor MCP interno ofrece control total sobre la privacidad de los datos. De este modo, la información permanece dentro de tu infraestructura.

- Eficiencia de costes y flexibilidad: los modelos eficientes de Mistral, combinados con la integración estandarizada del MCP, permiten ahorrar costes potenciales y ofrecen mayor flexibilidad en el despliegue, ya sea en la nube, en local o en el edge.

- Desarrollo impulsado por la comunidad: el carácter de código abierto fomenta la colaboración: los desarrolladores pueden crear y compartir herramientas MCP que enriquecen el ecosistema para todos.

- Retos: este enfoque suele requerir más experiencia técnica para configurar y mantener tanto el LLM como el servidor MCP. No ofrece la misma experiencia “lista para usar” que algunas plataformas propietarias.

- Ideal para: proyectos con necesidades estrictas de privacidad, desarrolladores que quieran control total de su stack de IA, u organizaciones que prioricen la portabilidad y la eficiencia de costes a largo plazo frente a soluciones empaquetadas y listas para usar.

Comparativa de LLM: cómo se alinean con el Model Context Protocol (MCP)

Para desglosar las diferencias con más claridad, veamos en detalle cómo se alinea cada LLM con el MCP:

Cómo elegir el LLM adecuado para tu agente de IA

La mejor opción depende de lo que quieres conseguir con tu proyecto.

- Elige ChatGPT si: quieres llegar a una audiencia amplia o integrarte sin complicaciones con herramientas ya populares. Aprovechando la gran base de usuarios y el ecosistema para desarrolladores de ChatGPT, podrás crear soluciones accesibles y escalables con relativa facilidad.

- Elige Claude si: necesitas una experiencia de agente muy fiable, segura y profundamente integrada en un entorno gestionado en la nube. Si te sientes cómodo trabajando dentro del ecosistema de Anthropic y confías en su implementación nativa del MCP, Claude suele ser la opción más sólida.

- Elige Mistral si: tu proyecto exige máxima portabilidad, control sobre la privacidad de los datos o ahorro de costes con despliegues on-premise. Si eres desarrollador o empresa que valora los modelos con pesos abiertos y quiere la flexibilidad de poder cambiar de LLM sin rehacer todo, Mistral es la opción indicada.

Conclusión

El Model Context Protocol (MCP) supone un avance clave para lograr un futuro más unificado y efectivo para los agentes de IA. Establece un marco común que permite a los modelos de lenguaje dejar de limitarse a mantener una conversación: ahora pueden interactuar de verdad con el mundo digital.

Al comparar ChatGPT, Claude y Mistral queda claro que, aunque el MCP estandariza el cómo, la filosofía de cada proveedor sigue condicionando el porqué y el modo de su implementación. Ya sea que necesites una integración fluida, un alcance masivo o máxima flexibilidad y control, el MCP ofrece una base sólida para cada enfoque. El auténtico salto de la IA no es solo crear modelos más inteligentes, sino desarrollarlos abiertos, interoperables y capaces de impulsar nuevos niveles de automatización y de generación de insights en todos los sectores.

Si quieres profundizar, consulta nuestros artículos sobre: cómo el MCP potencia a Claude en SEO y automatización de marketing, cómo transforma a ChatGPT más allá de los plugins, y cómo mejora los agentes interoperables de Mistral.