ChatGPT se ha convertido rápidamente en una herramienta de referencia para mantener conversaciones de calidad. Su capacidad para entender consultas complejas y ofrecer respuestas detalladas y bien fundadas ha cambiado la forma en que trabajamos y creamos. Pero para muchos usuarios, su valor real va más allá de la mera conversación. Con los Plugins y los GPTs personalizados, ChatGPT puede interactuar con el mundo exterior: desde incorporar datos del mercado bursátil en tiempo real hasta organizar tu agenda.

Aunque estas funciones son potentes, también tienen límites, principalmente porque funcionan dentro de un sistema cerrado y propietario. Para desarrolladores y empresas, eso supone un problema: el bloqueo por proveedor (vendor lock-in). Si quisieras integrar otro modelo de lenguaje grande (LLM), básicamente tendrías que reconstruirlo todo desde cero.

Aquí entra el Protocolo de Contexto de Modelos (MCP), una solución que podría cambiarlo todo. Desarrollado por el equipo de Anthropic, creadores de Claude, el MCP es un marco de código abierto que pretende estandarizar cómo los LLM se conectan con herramientas externas. Aunque no es una función oficial de OpenAI, entender el MCP es fundamental, porque abre la puerta a un futuro más abierto, flexible y potente para crear agentes de IA con ChatGPT. Es la herramienta que hace posible la verdadera interoperabilidad entre LLM.

En este artículo profundizaremos en por qué el MCP es tan importante para quienes usan ChatGPT, lo compararemos con las herramientas actuales de OpenAI y explicaremos cómo podría transformar por completo tu enfoque hacia la automatización de flujos de trabajo y la gestión de datos.

Entendiendo las herramientas e integraciones de ChatGPT

Antes de ver cómo el Protocolo de Contexto de Modelos (MCP) aporta valor, es importante entender primero el estado actual de las integraciones con la API de ChatGPT.

- Plugins de ChatGPT (legado): Cuando se introdujeron los plugins, se convirtieron en la forma principal de vincular ChatGPT con servicios externos. Instalabas un plugin desde un marketplace para permitir que el modelo realizara tareas específicas. Si bien este enfoque funcionaba, distaba mucho de ser perfecto. Para conectar distintas aplicaciones, por ejemplo, un CRM y un calendario, necesitabas plugins separados creados por desarrolladores diferentes, lo que hacía que el sistema resultara fragmentado.

- GPTs personalizados y Acciones (actual): La actualización más reciente de OpenAI, los GPTs personalizados, mejoró notablemente la experiencia. Ahora los desarrolladores pueden crear “Acciones” directamente dentro de un GPT concreto, ofreciendo una integración más fluida y cohesiva. Para los usuarios es un gran avance; sin embargo, para los desarrolladores la principal limitación permanece: esas integraciones quedan atadas a ese GPT específico y deben construirse sobre la plataforma de OpenAI. Por tanto, si quieres que tu herramienta funcione con otros modelos de lenguaje, como Claude de Anthropic o Gemini de Google, tendrías que empezar de cero.

Aunque este modelo beneficia a los usuarios, crea un ecosistema cerrado para los desarrolladores. Tu trabajo queda vinculado a un solo proveedor, lo que limita la capacidad de escalar, mover datos y desarrollar libremente en distintas plataformas.

Cómo el MCP soluciona la fragmentación en la integración de LLM

El mundo digital se sostiene sobre estándares abiertos. Piensa en HTTP para la web o en SMTP para el correo: esos protocolos permiten que sistemas distintos se comuniquen sin problemas. En el terreno de los modelos de lenguaje (LLM) faltaba un estándar así hasta la llegada del Protocolo de Contexto de Modelos (MCP).

El MCP ataca el problema de la fragmentación introduciendo un estándar universal. En vez de desarrollar una “acción” distinta para cada LLM, un desarrollador sólo necesita crear un servidor MCP que ofrezca un conjunto de herramientas. Cualquier LLM que entienda el MCP puede conectarse a ese servidor y usar sus herramientas, sin importar quién haya creado el modelo.

Este cambio es fundamental: desplaza el esfuerzo de crear integraciones por modelo a construir un puente universal. Para desarrolladores y empresas esto supone:

- Menos tiempo de desarrollo: creas una sola capa de integración y funciona con cualquier LLM que soporte el protocolo.

- Mayor control: mantienes la propiedad y el control sobre tu servidor MCP y tus datos, en lugar de depender de marketplaces ajenos.

- Preparación a futuro: tus aplicaciones de IA no quedan atadas a la hoja de ruta de un único proveedor. Si aparece un LLM nuevo y mejor, sólo apuntas tu servidor MCP hacia él y tus aplicaciones siguen funcionando sin cambios.

MCP frente a Plugins y GPTs personalizados: diferencias clave

Para apreciar realmente el valor del Protocolo de Contexto de Modelos (MCP), conviene compararlo directamente con las herramientas actuales de OpenAI.

Esta comparación pone de relieve las diferencias esenciales. Mientras que las soluciones de OpenAI priorizan la facilidad de uso y una experiencia integrada dentro de su propio ecosistema, el MCP apuesta por la flexibilidad y el control, transformando el panorama para los desarrolladores que buscan mayor libertad en sus integraciones.

Cómo usar el MCP con ChatGPT

El Protocolo de Contexto de Modelos (MCP) destaca por su flexibilidad. No es una solución única para todo, sino un protocolo que se puede adaptar según las necesidades. Desde su introducción a finales de 2024 y su implementación completa en septiembre de 2025, el MCP ha ofrecido dos enfoques principales para integrarse con ChatGPT.

1. Usar un GPT personalizado

Esta opción ofrece la experiencia más pulida y amigable para el usuario. Es ideal para desarrolladores y empresas que quieran crear un agente propio y con marca para una tarea concreta.

Flujo de trabajo:

- Acción del desarrollador: el desarrollador monta y hospeda un servidor MCP seguro en una URL pública (o utiliza un proveedor externo). En ese servidor reside la lógica y las claves API de las herramientas externas que va a usar el agente.

- Configuración del GPT: el desarrollador crea un GPT personalizado en la plataforma de OpenAI. En los ajustes de “Acciones” del GPT pega la URL de su servidor MCP y define las herramientas a las que se conecta. Esta configuración se hace una sola vez y el usuario final no la ve.

- Experiencia del usuario final: el usuario interactúa con el GPT personalizado como en cualquier chat. Cuando una petición requiere una acción externa, por ejemplo “Resume nuestros datos de ventas del tercer trimestre”, ChatGPT detecta que debe invocar una de las acciones predefinidas. El servidor MCP procesa la solicitud, envía los resultados al GPT y este genera la respuesta final.

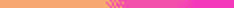

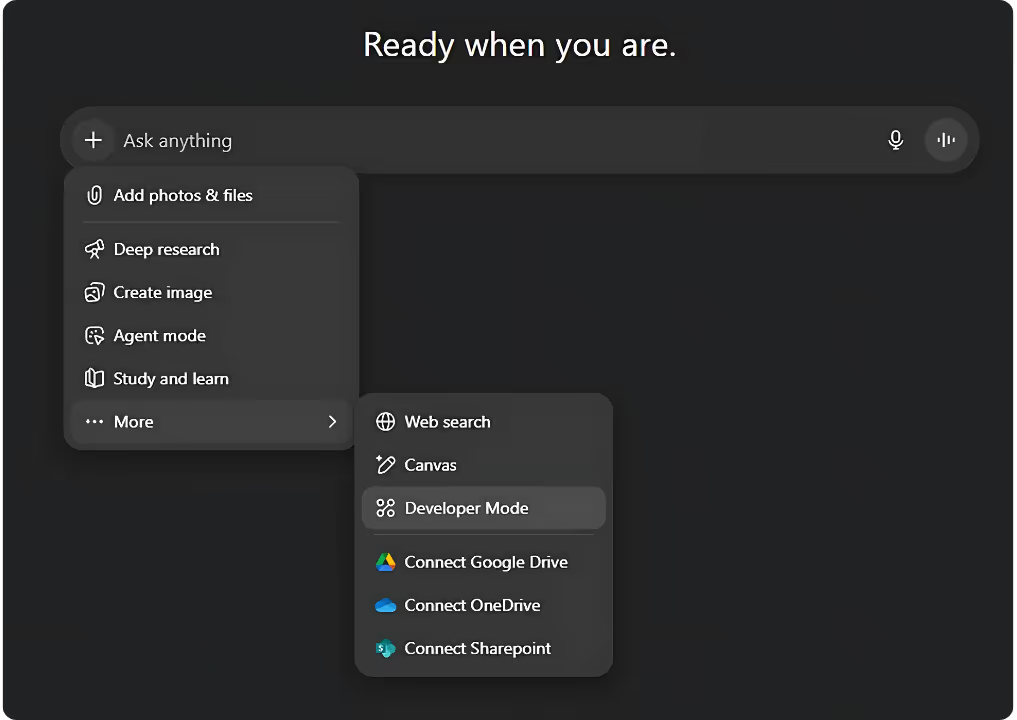

2. Conversación normal

Este flujo está pensado para usuarios avanzados, administradores o desarrolladores que necesiten acceder rápidamente a una herramienta sin crear un agente completo. Es una funcionalidad clave de la implementación completa del MCP, desplegada en septiembre de 2025.

Flujo de trabajo:

- Configuración inicial: el usuario (o el administrador del sistema) habilita el “Modo desarrollador” en los ajustes de ChatGPT. Desde ahí añade el servidor MCP externo pegando su URL. Es una acción manual del usuario que autoriza ese servidor concreto.

- Acción del usuario: en un chat normal, el usuario puede escribir un prompt que haga referencia directa a una herramienta conectada al servidor. Por ejemplo, si hay un servidor de datos financieros conectado, podría preguntar: “¿Cuál es el precio actual de la acción de APPL?”

- Conexión en tiempo real: ChatGPT detecta la intención de usar una herramienta externa, hace la llamada en tiempo real al servidor MCP, obtiene los datos y muestra el resultado en el chat. Este método es on-demand y activado por el usuario, sin necesidad de un agente preconfigurado.

Por qué una URL de confianza importa para la seguridad

En ambos flujos, un factor clave es la fiabilidad de la URL del servidor MCP. Al conectar un servidor MCP permites que el LLM interactúe con un sistema externo.

Un servidor MCP malicioso o no fiable podría ejecutar comandos dañinos o acceder a datos sensibles. Por eso es vital conectar únicamente servidores MCP provistos por fuentes fiables y bien documentadas. Un servidor MCP de confianza debería:

- Estar alojado en un dominio seguro y usar HTTPS.

- Ofrecer una especificación pública y clara de las herramientas que expone.

- Seguir las mejores prácticas de seguridad, incluyendo autenticación robusta y controles de acceso sólidos.

Auditoría de contenido entre plataformas: cómo el MCP lo facilita

El paso de un modelo de plugins propietarios a un protocolo de estándar abierto abre un mundo de posibilidades para profesionales de distintos sectores.

- Flujos de trabajo de marketing más ágiles: imagina contar con un único agente de IA capaz de gestionar campañas en varias plataformas. Podría analizar el rendimiento de anuncios en Google Ads, extraer información de clientes desde Salesforce y actualizar automáticamente el calendario de contenidos en un CMS, todo a través de un mismo protocolo estandarizado. Esto permitiría automatizaciones de extremo a extremo mucho más fluidas, ahorrando tiempo y esfuerzo.

- Auditoría de contenido multiplataforma: un estratega de contenidos podría usar un agente ChatGPT con MCP para extraer datos de una base de conocimiento interna mediante la API de una base de datos y contrastarlos con las tendencias de palabras clave en tiempo real de una herramienta SEO. El agente podría generar después un análisis detallado de brechas de contenido, ofreciendo insights precisos y actualizados.

- Control de datos y seguridad: para las empresas, proteger la información es crucial. Al hospedar su propio servidor MCP, las compañías pueden mantener los datos sensibles bajo su control y evitar que pasen por plataformas de terceros. Además, si en el futuro deciden cambiar a otro LLM, migrar todo el flujo de automatización puede realizarse con muy poca fricción.

Conclusión

El Protocolo de Contexto de Modelos no es solo una alternativa más al sistema de plugins de OpenAI; supone un paso importante hacia un futuro de IA más abierto y flexible. Aunque las herramientas de OpenAI son muy amigables para el usuario, el MCP ofrece a desarrolladores y empresas la vía para recuperar el control, evitar el vendor lock-in y construir sistemas de IA que realmente puedan interoperar.

El futuro de la IA no estará determinado únicamente por el modelo más potente, sino por el ecosistema más efectivo y abierto. Explorar el MCP no es solo adoptar una tecnología nueva: es apoyar la idea de sistemas basados en estándares abiertos, lo que a la larga puede dar lugar a soluciones más creativas e innovadoras.

Para profundizar en cómo el Protocolo de Contexto de Modelos (MCP) está transformando la IA, consulta nuestros artículos sobre cómo el MCP desbloquea el potencial de Claude para SEO y automatización de marketing, cómo potencia los agentes interoperables de Mistral, y la comparación detallada “Claude, ChatGPT y Mistral: ¿qué LLM es mejor para tu agente de IA?”.