Los modelos de lenguaje a gran escala (LLMs) se han convertido en tecnologías clave. Sin embargo, suele haber un problema: normalmente estos modelos están recluidos en sistemas propietarios. Ahí es donde aparece Mistral AI, rompiendo con esa dinámica. Conocida por crear modelos eficientes y de alto rendimiento, Mistral ofrece a desarrolladores y empresas una alternativa que pone el énfasis en la transparencia, el control y la apertura.

Pero incluso los LLM más potentes, ya sean de código abierto o propietarios, afrontan un reto importante: cómo interactuar con el mundo exterior de forma segura y fiable. Justo en ese punto el Protocolo de Contexto del Modelo (MCP) se vuelve esencial para Mistral. Creado originalmente por Anthropic, el MCP es un estándar abierto que funciona como ese puente imprescindible, transformando los modelos de Mistral en agentes de IA dinámicos capaces no solo de razonar, sino de actuar.

Para profesionales de marketing, SEO o estrategia de contenidos, conviene entender cómo el enfoque abierto de Mistral encaja con el marco estandarizado del MCP. La combinación permite crear soluciones de IA que no solo son potentes y eficientes, sino también adaptables, respetuosas con la privacidad y preparadas para el futuro. En este artículo exploraremos por qué el MCP es el complemento perfecto para la visión de Mistral, mostrando sus ventajas distintivas y casos de uso reales.

Por qué la filosofía de Mistral destaca: potencia, eficiencia y apertura

Antes de entrar en el Protocolo de Contexto del Modelo, conviene entender qué hace que Mistral AI sobresalga en un mercado dominado por grandes actores tecnológicos. Mistral propone un enfoque refrescante respecto a los LLM, especialmente para desarrolladores y empresas que buscan mayor control y flexibilidad.

- Eficiencia como base: los modelos de Mistral son famosos por ofrecer un rendimiento de primer nivel manteniendo un tamaño reducido, sobre todo frente a modelos cerrados y voluminosos. Eso se traduce en menores costes computacionales, respuestas más rápidas y la posibilidad de desplegar la IA más cerca de donde residen los datos, ya sea on-premise o en dispositivos edge. Para las empresas, significa IA rápida y rentable.

- Modelos con pesos abiertos: una de las características más distintivas de Mistral es su compromiso con modelos de “pesos abiertos”. A diferencia de los LLM cerrados, donde el funcionamiento interno está oculto, Mistral permite descargar, inspeccionar y afinar sus modelos. Esta transparencia genera confianza y facilita la personalización, incentivando además a la comunidad de desarrolladores a aportar e innovar.

- Una mentalidad pensada para desarrolladores: las herramientas y la documentación de Mistral están diseñadas para facilitar el trabajo del desarrollador, ofreciendo control, flexibilidad y acceso sencillo. Este enfoque contrasta con ecosistemas más restrictivos y dependientes de una plataforma concreta, lo que convierte a Mistral en una opción ideal para empresas que necesitan personalización y valoran la soberanía de sus datos.

El enfoque de Mistral en eficiencia y apertura la hace atractiva para quienes quieren IA potente sin las limitaciones de sistemas propietarios. Aun así, incluso los modelos open-source afrontan el reto de interactuar con diferentes herramientas externas; y ahí es donde entra en juego el Protocolo de Contexto del Modelo.

Cómo el MCP desbloquea todo el potencial de los agentes de Mistral

Los modelos de Mistral son muy buenos razonando y suelen incluir potentes capacidades de “llamado de funciones”, es decir, pueden sugerir acciones a ejecutar. Pero eso por sí solo no garantiza interoperabilidad real. Sin un protocolo universal, los desarrolladores tendrían que crear soluciones a medida para conectar Mistral con sistemas externos: CRMs, APIs de correo, bases de datos, lo que conduciría a incoherencias y trabajo duplicado.

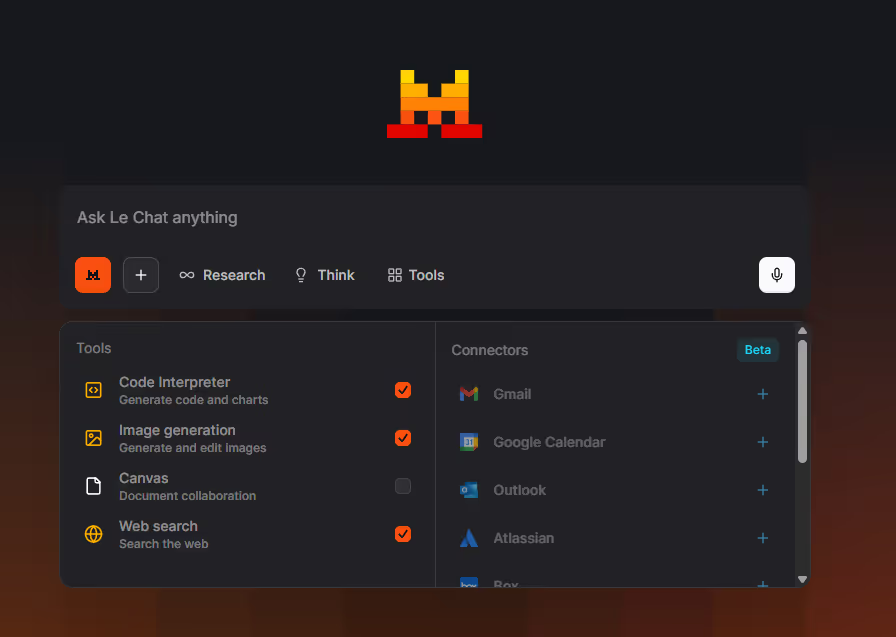

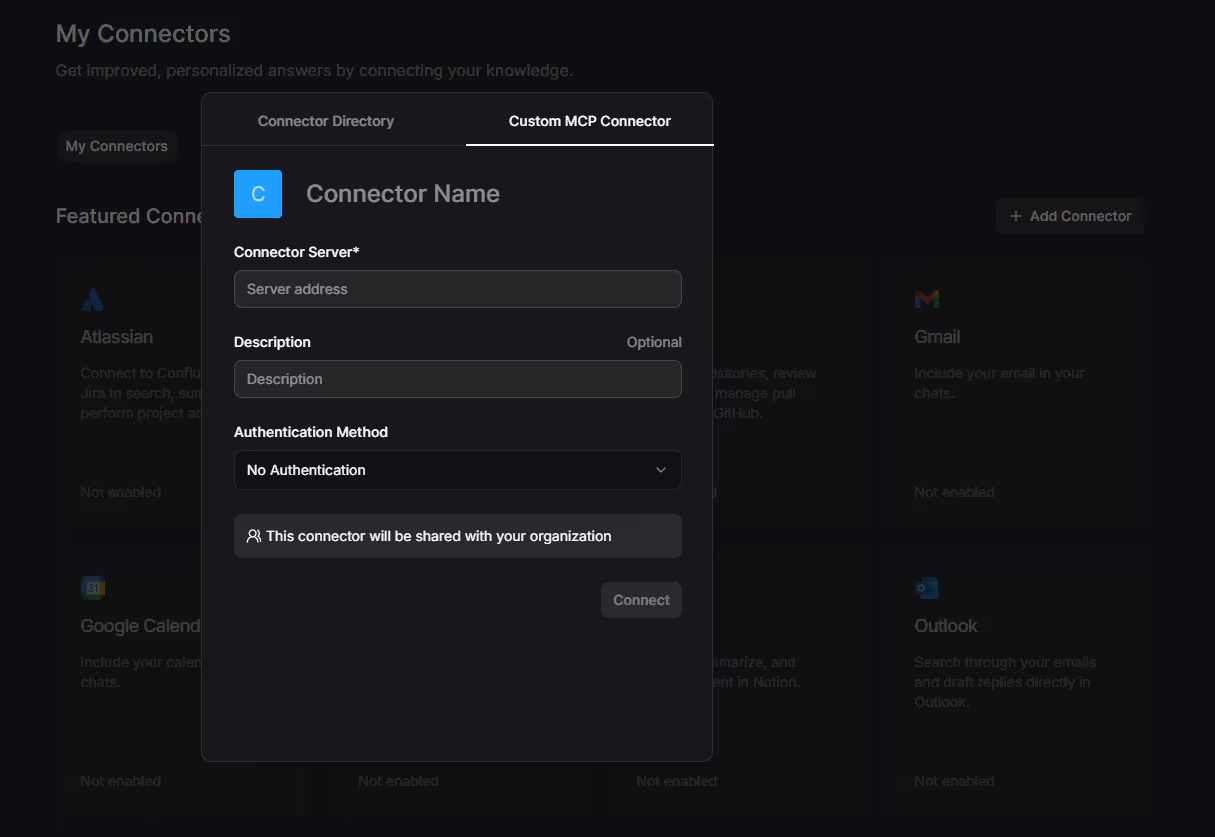

Ahí entra el Protocolo de Contexto del Modelo (MCP). Cierra esa brecha al ofrecer un marco estandarizado para definir y usar herramientas, permitiendo que Mistral se conecte de forma fluida con distintos sistemas externos. No es solo un detalle técnico: es una asociación estratégica que potencia las ventajas únicas de Mistral:

- Fomentar la apertura mediante estándares: Mistral aporta la inteligencia de código abierto y el MCP, la capa de comunicación también abierta que la conecta. Juntos crean un ecosistema verdaderamente abierto, donde los desarrolladores no quedan atados a métodos de integración propietarios. Esto facilita la colaboración, porque cualquier LLM compatible con MCP puede usar las herramientas diseñadas para él.

- Simplificar el desarrollo de agentes: Para quienes trabajan con los modelos de Mistral, el MCP agiliza la creación de agentes de IA. En lugar de construir integraciones separadas para cada API, los desarrolladores pueden exponer sus herramientas a través de un único servidor MCP que Mistral entiende y utiliza fácilmente. Resultado: menos tiempo de desarrollo y menor complejidad.

- Garantizar la portabilidad: Este es un beneficio clave. Un agente creado con Mistral y un servidor MCP resulta mucho más portable: si aparece un modelo Mistral más potente o si se cambia a otro LLM compatible con MCP, la lógica de integración (el servidor MCP) se mantiene igual.

La combinación de Mistral y el MCP es bastante poderosa: Mistral ofrece un LLM eficiente y transparente, y el MCP proporciona el marco abierto y estandarizado necesario para conectar esa inteligencia con sistemas reales. Juntos representan una alternativa sólida a los ecosistemas cerrados, poniendo el foco en la flexibilidad y en dar a los desarrolladores mayor control.

Explorando casos de uso reales con Mistral y MCP

Al combinar las capacidades de Mistral con el Protocolo de Contexto del Modelo (MCP) se abren aplicaciones potentes y distintivas, especialmente para organizaciones que priorizan el control de datos, la eficiencia de costes y la flexibilidad en el despliegue.

IA privada y local para datos sensibles

En sectores como finanzas, salud o legal, donde la privacidad y el cumplimiento normativo son críticos, ejecutar LLMs en las propias instalaciones suele ser imprescindible.

Escenario: Una entidad financiera necesita usar IA para analizar informes internos de riesgo o atender consultas de clientes sin enviar datos a servicios en la nube.

Flujo de trabajo:

- La entidad instala un modelo de Mistral (por ejemplo, Mistral 7B u 8x7B) directamente en sus servidores internos.

- Se despliega un servidor MCP dentro del mismo entorno seguro, conectado a las bases de datos propietarias, sistemas heredados y herramientas de comunicación internas, todo dentro del perímetro de red de la empresa.

- Gracias al MCP, un agente potenciado por Mistral puede procesar consultas, generar informes de cumplimiento, resumir documentos sensibles e interactuar con sistemas internos, manteniendo siempre los datos de forma segura dentro de la red empresarial.

Ventaja única: Esta configuración ofrece un agente de IA que no solo es potente, sino totalmente privado y seguro, capaz de cumplir los estrictos requisitos regulatorios que a menudo dificultan el uso de LLMs basados en la nube.

Aplicaciones de IA flexibles y fácilmente evolucionables

Para desarrolladores y startups, poder adaptar y escalar soluciones de IA sin rediseños importantes supone una ventaja competitiva notable.

Escenario: Una startup crea un asistente de IA para la gestión de proyectos que ayuda a los equipos a organizar tareas, resumir reuniones y seguir el progreso.

Flujo de trabajo:

- El desarrollador instala un servidor MCP que se conecta con herramientas de gestión (por ejemplo, Jira o Asana) y plataformas de comunicación (como Slack).

- Inicialmente, por motivos de coste y velocidad, usan un modelo Mistral más pequeño y eficiente (por ejemplo, Mistral 7B) ejecutado localmente o en una instancia ligera en la nube. El servidor MCP permite al asistente probar y activar sus funciones de IA.

- A medida que la aplicación crece o se necesita más potencia de cómputo, el desarrollador puede cambiar fácilmente a un modelo Mistral más potente (por ejemplo, Mistral Large) o incluso migrar a otro LLM compatible con MCP, mientras el servidor MCP y sus integraciones de herramientas permanecen sin modificaciones.

Ventaja única: Este enfoque ofrece una portabilidad incomparable. Al separar la lógica central de interacción con las herramientas externas del propio LLM, las empresas pueden elegir en cualquier momento el modelo que mejor se adapte a sus necesidades sin enfrentarse a costosas reingenierías o reintegraciones.

Cómo la combinación de Mistral y MCP te da una ventaja estratégica

La fortaleza real de unir los modelos de pesos abiertos de Mistral con el Protocolo de Contexto del Modelo no se reduce únicamente al rendimiento técnico; radica en la ventaja estratégica de la interoperabilidad. En una época en la que la IA evoluciona rápidamente, la flexibilidad es esencial.

A diferencia de los usuarios de LLM propietarios como ChatGPT o Claude, que a menudo quedan atados a características, modelos de precios y planes a largo plazo de una sola plataforma, la combinación Mistral–MCP ofrece un enfoque más abierto:

- Libertad de elección: las organizaciones dejan de depender de un único proveedor de LLM. Pueden escoger el modelo que mejor se adapte a sus necesidades de rendimiento, coste o privacidad dentro de un ecosistema open-source en crecimiento, con la tranquilidad de que sus integraciones existentes seguirán funcionando sin fricciones.

- Mayor control: al alojar sus propios modelos Mistral y servidores MCP, las empresas tienen control total sobre sus datos, la lógica de IA y el despliegue. Este tipo de autonomía es clave para mantener el cumplimiento normativo, la seguridad y la independencia estratégica.

- Innovación impulsada por la comunidad: la apertura tanto de Mistral como del MCP fomenta una comunidad activa. Esto acelera el intercambio de herramientas compartidas, buenas prácticas e ideas nuevas, permitiendo una innovación a un ritmo que los ecosistemas propietarios suelen tener dificultad para igualar.

Conclusión

El Protocolo de Contexto del Modelo es mucho más que un detalle técnico; es una fuerza motriz que convierte la visión de una IA abierta, eficiente y potente en algo real. Para Mistral AI, el MCP es la clave que permite que sus modelos de alto rendimiento y pesos abiertos vayan más allá del razonamiento y puedan actuar en el mundo real, interactuando sin problemas con una amplia variedad de sistemas externos.

Para profesionales de marketing, SEO y estrategia de contenidos, esta alianza representa una alternativa sólida. Abre la posibilidad de crear agentes de IA bien integrados en los flujos de trabajo existentes, capaces de manejar datos sensibles on-premise y preparados para adaptarse a futuros cambios tecnológicos. La verdadera revolución de la IA no vendrá solo de construir modelos más grandes o complejos; vendrá de facilitar y estandarizar la forma en que esos modelos se conectan con el mundo. Mistral y el MCP lideran ese cambio, no solo con sus productos, sino estableciendo los estándares abiertos que marcarán la próxima generación de aplicaciones inteligentes.

Si te interesa profundizar, consulta también nuestros otros artículos sobre cómo el Protocolo de Contexto del Modelo está transformando el panorama de la IA: Cómo el MCP está desbloqueando el potencial de Claude para SEO y automatización de marketing, Más allá de los plugins: cómo el MCP está cambiando ChatGPT y MCP en Claude vs. ChatGPT vs. Mistral: ¿qué LLM es mejor para tu agente de IA?.